Upmem place le processeur dans la mémoire

Créée en 2015, Upmem développe des dispositifs dédiés au Big Data faisant cohabiter mémoire et processeur, afin d’améliorer la vitesse et les performances énergétiques des calculs.

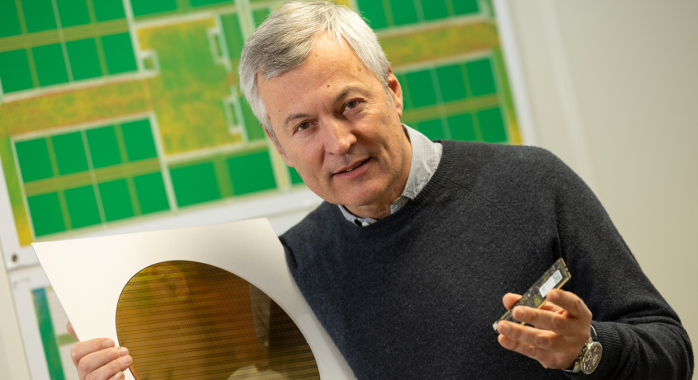

Tandis que les quantités de données transitant par les serveurs explosent, rendant les calculs toujours plus complexes et gourmands en énergie, Upmem propose des architectures programmables d’accélération des applications d’intelligence artificielle (IA) destinées au Big Data. Contrairement aux architectures classiques, dans lesquelles le processeur et la mémoire sont séparés physiquement, la puce d’Upmem intègre des éléments de calcul directement au cœur de la mémoire. « Comme le mouvement continu des données entre la mémoire principale (vive) et le processeur est à l’origine de 80 % de la consommation énergétique du circuit, et qu’il est contraint, notre dispositif permet d’accélérer 20 fois le calcul, tout en consommant 7 à 8 fois moins d’énergie, explique Gilles Hamou, PDG et cofondateur d’Upmem. Notre force est d’avoir conçu un processeur qui s’intègre dans la mémoire, tout en respectant les caractéristiques de cette dernière. »

Vers les applications d’IA générative

Créée en 2015, la start-up a réalisé l’an passé une deuxième levée de fonds de 6,6 M€, dont 2,5 millions de subventions du fonds du Conseil européen de l’innovation (EIC). Le reste – en fonds propres – provient de l’EIC et d’investisseurs en capital-risque. Cette manne est destinée à financer la commercialisation de la version actuelle de la puce Upmem, et au développement de la prochaine, qui sera spécialement dédiée aux applications d’« IA générative », telles ChatGPT. Tout comme le dispositif actuel, cette prochaine génération de puce ciblera d’abord les marchés des fournisseurs de cloud. Elle a vocation à être dix fois moins énergivore et vingt fois moins chère que les meilleurs dispositifs actuels, et devrait être commercialisée en 2025.

L. Marty

Infos clés

Solution d’accélération du traitement big data pour les datacenters

Marchés : les fournisseurs de cloud (une trentaine de clients en portefeuille actuellement).

Localisation : un bureau et centre R&D à Grenoble, un bureau à Paris. Ouverture d’une présence en Chine début 2024.

Commentaires

Ajouter un commentaire